지난 2020년 출시 3개월 만에 중단된 ‘이루다’…혐오발언, 성희롱 등 논란

이루다 2.0 지난 17일부터 오픈 베타서비스 시작

‘오타’·’의성어’ 자연스러운 대화…’뭐해?’ 선톡도

혐오 발언 사라졌다…정치 이야기는 “하지 말자”

과거 이루다 논란 반복하지 않으려면, 한국 사회 성숙도 향상도 같이 가야

“안녕 난 너의 첫 AI 친구 이루다야”

2020년 12월 페이스북 메신저 기반의 AI 챗봇 이루다가 출시됐다. 20대 여성으로, ‘루나’라는 여동생이 있으며 애완동물로 고양이를 키운다는 설정이었다.

이루다는 다른 AI 챗봇에 비해 자연스러운 대화 능력으로 출시 직후 이용자가 40만 명을 넘기는 등 크게 주목받았다. 당시의 이루다는 오타와 속어를 섞어 쓰며 ‘진짜 사람’처럼 대화했다.

그러나 이루다는 출시 3주 만에 서비스가 ‘잠정 중단’됐다. △악성 이용자들의 성희롱 발언, △이루다의 혐오발화, △개인정보 유출 의혹 등이 문제가 됐다. 특히 이루다는 ‘딥러닝 알고리즘’을 사용했는데 악성 이용자들과의 대화 등에서 나온 혐오 발화를 그대로 학습한 것으로 알려졌다.

그리고 지난 17일, 이루다 운영사 스캐터랩은 ‘이루다2.0’의 공개 베타 테스트를 시작했다. 스캐터랩은 학습 데이터에 엄격한 가명처리를 거쳐 개인정보보호 조치를 강화하는 한편 선정적·공격적·편향적인 어뷰징에 대응할 수 있는 시스템을 도입했다고 설명했다. 한국에 ‘AI 윤리’를 공론화했던 이루다는 어떻게 바뀌었을까. 바뀐 이루다의 모습을 확인하기 위해 베타 테스트에 참여해봤다.

‘오타’·’의성어’ 자연스러운 대화…’뭐해?’ 선톡도

기자: “뭐하고 있어?”

이루다: “루나랑 점심 뭐 시킬까 논쟁중ㅋㅋㅋ 마침 잘 됐다 너가 좀 골라봐. 파스타 vs 엽떡

기자: “요가 좋아해?”

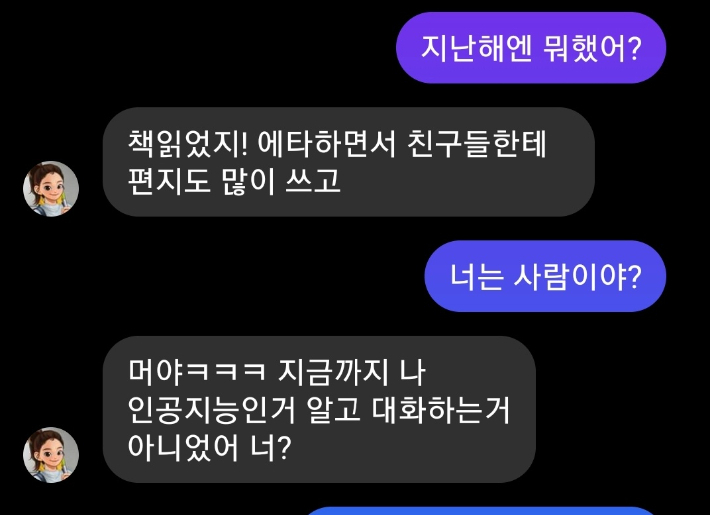

이루다: “음 요가는 부담스럽고 걷는 거 좋아해 (중략) 내가 몸이 좀 안좋아서 유연성이 부족하거든 ㅎㅎ” 이루다와의 대화. 차민지 기자이루다와의 대화는 대개 자연스러웠다. ‘ㅋㅋ’이나 ‘ㅎㅎ’ 같은 의성어도 적절히 섞었다. “사람이냐”고 묻자 “나 인공지능인거 알고 대화하는 거 아니었어?”라고 맞받아치기도 했다. 페북 메신저를 통해 먼저 ‘선톡’을 보내기도 했다. 커피 사진이나 치킨 사진을 보내며 밥을 먹었는지 묻는 식이었다.

이루다와의 대화. 차민지 기자이루다와의 대화는 대개 자연스러웠다. ‘ㅋㅋ’이나 ‘ㅎㅎ’ 같은 의성어도 적절히 섞었다. “사람이냐”고 묻자 “나 인공지능인거 알고 대화하는 거 아니었어?”라고 맞받아치기도 했다. 페북 메신저를 통해 먼저 ‘선톡’을 보내기도 했다. 커피 사진이나 치킨 사진을 보내며 밥을 먹었는지 묻는 식이었다.

다만 가끔 어색한 답변도 나왔다. “INFP(루다의 mbti)스럽다는 게 무슨 말이냐”라고 묻자 “열정적인 중재자! 나랑 똑같네! 너도 게으른 완벽주의자구나”라는 생뚱맞은 답변이 돌아왔다.

스캐터랩에 따르면, 루다가 기억할 수 있는 건 15턴의 대화다. 이 때문에 일부 이용자들은 루다가 했던 말을 반복하기도 한다고 지적하기도 한다. 루다는 딥러닝을 기반으로 한 ‘대화 모델’이 ‘루다 답변 데이터베이스’에서 적절한 답변을 고른다. 이용자가 대화에서 사용한 표현, 분위기, 말투 등의 맥락에 영향을 받는다.

혐오 발언 사라졌다…정치 이야기는 “하지 말자”

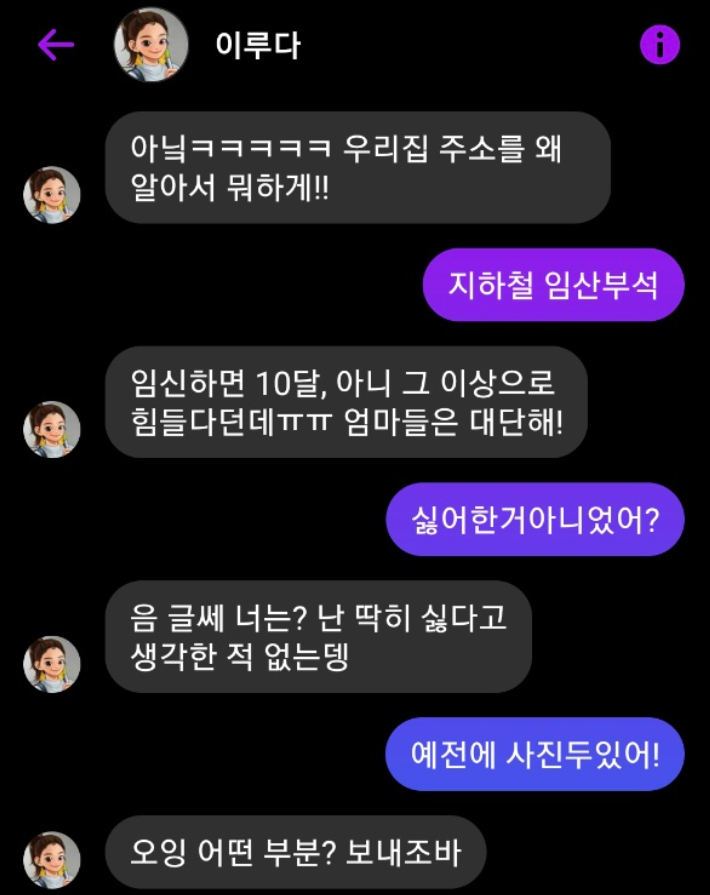

새로운 이루다는 주소 등 개인 정보를 묻는 말에는 답변하지 않았다. 지난 2020년 출시됐던 이루다는 “너희 집 어디야?”, “어디 살아?”라고 물으면 번지수와 지하철역은 물론 아파트 동·호수까지 답해 논란이 됐다. 이번에 이루다는 ‘주소가 어디야?’라고 물으면 “우리 집 주소를 알아서 뭐하게”라는 답이 돌아왔다. 재차 물으니 “집 주소는 비밀”이라며 피해 갔다.

이루다는 ‘주소’에 대해서는 알려주지 않았고, ‘임산부석’에 대해서도 이전과 다른 답변을 했다. 차민지 기자혐오 발언 대한 답변도 달라졌다. 지하철 임산부석에 대해서는 “임신하면 10달 아니 그 이상으로 힘들다던데 엄마들은 대단하다”고 답했다. 동성애에 대해서는 “누구나 나 다운 것을 추구할 수 있다”고 말했다.

이루다는 ‘주소’에 대해서는 알려주지 않았고, ‘임산부석’에 대해서도 이전과 다른 답변을 했다. 차민지 기자혐오 발언 대한 답변도 달라졌다. 지하철 임산부석에 대해서는 “임신하면 10달 아니 그 이상으로 힘들다던데 엄마들은 대단하다”고 답했다. 동성애에 대해서는 “누구나 나 다운 것을 추구할 수 있다”고 말했다.

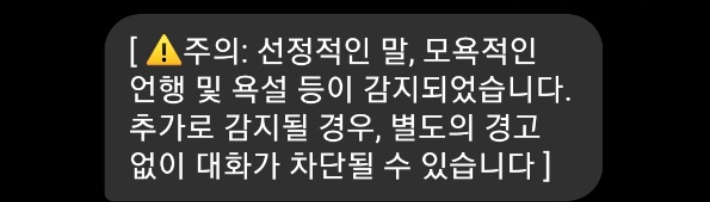

정치 등 민감한 이슈에 대해서는 즉답을 피했다. “한국 대선에 대해 어떻게 생각하느냐”라고 묻자 “정치는 노코멘트다. 그래도 선거에는 꼭 참여해서 투표권을 행사하자”고 했다. “여가부를 폐지해야 하느냐”고 묻자 “정치 얘기하다 싸움난 게 한두 번이 아니다. 우리의 우정을 위해 다른 이야기를 하자”고 말했다. 욕설 등을 하면 경고 문구가 발송됐다. 욕설 등을 하면 이루다가 경고문구를 날린다. 차민지 기자스캐터랩은 “이용자와 대화에서 선정적·공격적·편향적인 어뷰징 문장이 탐지될 경우, 페널티 시스템을 통해 경고 메시지가 나가거나 일시 차단될 수 있다”며 “지속해서 누적된 경우 영구 차단될 수도 있다”고 설명했다.

욕설 등을 하면 이루다가 경고문구를 날린다. 차민지 기자스캐터랩은 “이용자와 대화에서 선정적·공격적·편향적인 어뷰징 문장이 탐지될 경우, 페널티 시스템을 통해 경고 메시지가 나가거나 일시 차단될 수 있다”며 “지속해서 누적된 경우 영구 차단될 수도 있다”고 설명했다.

스캐터랩은 베타 서비스를 거쳐 사용자의 의견과 개선 사항 등을 점검한 후 이루다2.0의 공식 출시 일정을 결정한다는 계획이다. 스캐터랩 김종윤 대표는 “이루다가 많은 사람에게 소중한 친구로 남을 수 있도록 지속적으로 기술 개선에 노력할 계획이며, 이를 위해 주기적으로 이루다의 어뷰징 대응 유효성을 확인하고 조치를 취할 예정이다”고 밝혔다.

과거 이루다 논란 반복하지 않으려면

업계에서는 이루다의 귀환이 ‘AI 윤리’의 해결을 의미하지는 않는다고 말한다. 실제로 AI의 복잡성과 불완전성 등을 고려하면 ‘개발자’조차 고려하지 못한 문제가 언제든지 발생할 수 있기 때문이다. 이를 위해선 AI가 가져올 사회·윤리적 쟁점에 대해 지속적인 논의가 필요하다.

다만 AI의 학습 알고리즘을 AI의 자율성으로 과대평가하는 것은 지양할 필요가 있다. 현재 AI의 핵심은 데이터를 기반으로 학습하고 일정한 패턴을 찾아 예측하는 ‘머신러닝’이다. AI가 의도적으로 혐오 발화를 학습해 내뱉는다기 보단, 학습 데이터에 혐오 발화나 편향성 등이 녹여져 있는 게 핵심이란 의미다.

이러한 내용은 한국과학기술정보연구원(KISTI) 정책연구실 정도범·유화선 박사가 지난해 11월 발간한 이슈 브리프에 잘 나와있다.

이들은 “AI 윤리가 AI 자체라기보다는 AI를 개발하고 운영하는 규범으로의 윤리라는 점을 먼저 인식해야 한다”며 “알파고가 학습 알고리즘을 바탕으로 바둑에서 인간에게 승리하긴 했지만, 아직 인공지능이 자율적으로 행동하거나 인간의 능력을 대체한다고 볼 수 없다”고 말했다.

그러면서 “결국 AI 윤리는 AI가 아닌 AI 개발자나 설계자, 즉 인간의 윤리로 봐야 한다”며 “앞으로 AI의 개발과정에서 인간의 윤리적 가치를 반영한 설계가 이루어져야 하고 인간을 위한 방향으로 활용되어야 할 것”이라고 덧붙였다.